Das Sprachmodell wird von derselben Firma hergestellt, die Stable Diffusion Imager entwickelt hat, und verspricht ähnliche Ergebnisse wie GPT-3 mit größerer Effizienz.

Es ist bekannt, dass sich die KI in den letzten Monaten mit Stable Diffusion, einem KI-Bildgebungsmodell, stabilisiert hat. Nun begeben Sie sich in den Bereich des Schreibens. Das Unternehmen kündigte eine Open-Source-Alternative zu ChatGPT namens StableLM an.

StableLM generiert ein Skript, indem es vorhersagt, was das nächste Token ist und wie das Wortfragment heißt. Die Sequenz beginnt mit den Informationen, die der Mensch bereitstellt.

Es funktioniert sehr ähnlich wie GPT-4, das Large Language Model (LLM), das als Grundlage für ChatGPT dient.

„Sprachmodelle werden das Rückgrat unserer digitalen Wirtschaft bilden, und wir möchten, dass jeder bei diesen Entwürfen mitreden kann“, sagt Stability AI in dem Blogbeitrag, in dem die Neuigkeiten angekündigt werden. „Modelle wie StableLM zeigen unser Engagement für KI-Technologien, die transparent, zugänglich und unterstützend sind.“

StableLM verspricht effizienter zu werden

Im Moment befindet sich StableLM in der Alpha-Phase. Auf GitHub verfügbar gemacht, mit Größen von 3 Milliarden und 7 Milliarden Parametern. Stability AI verspricht, bald 15 Milliarden und 65 Milliarden Parametermodelle zu veröffentlichen.

Parameter sind die Variablen, die das Modell verwendet, um aus den Trainingsdaten zu lernen. Kleinere Zahlen bedeuten, dass Modelle effizienter sein können, da sie lokal auf Laptops oder Smartphones ausgeführt werden können.

Andererseits brauchen sie detailliertere Projekte, um mit weniger Ressourceneinsatz gute Ergebnisse zu erzielen.

StableLM ist ein weiteres großes Sprachmodell, das eine Leistung nahe GPT-3 von OpenAI mit weniger Parametern verspricht – GPT-3 verwendet 175 Milliarden.

Andere sind Meta LLaMA. Alpaka in Stanford; Transportwagen 2.0; und Cerebras-GPT.

Vorlagen werden unter einer Creative Commons BY-SA-4.0-Lizenz bereitgestellt. Das bedeutet, dass abgeleitete Projekte dem ursprünglichen Autor gutgeschrieben und unter derselben Lizenz geteilt werden müssen.

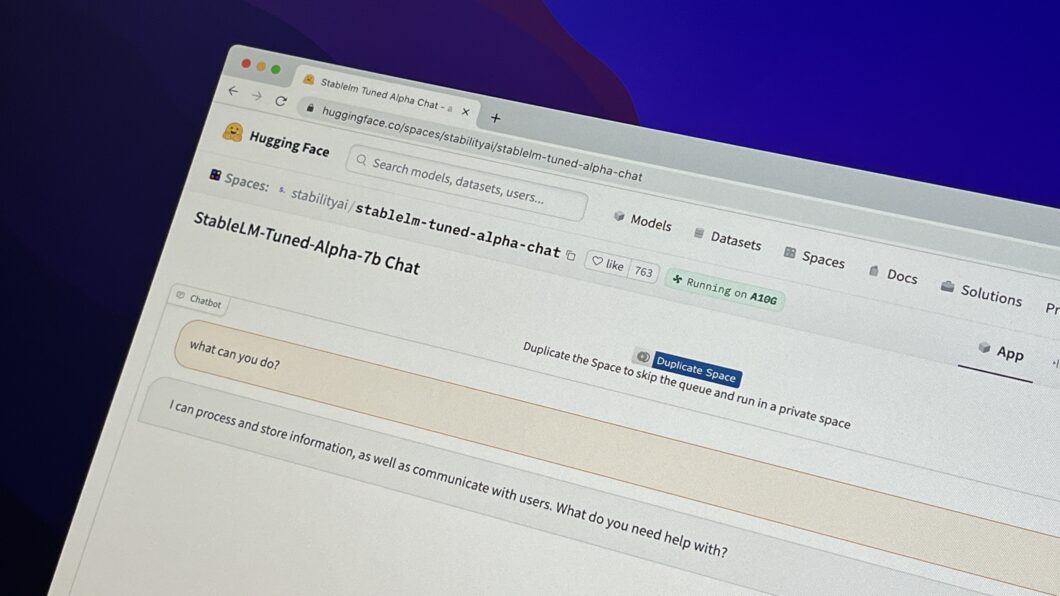

Derzeit ist es möglich, eine Version des Modells mit 7 Milliarden Parametern zu testen, die bereits für Chatbots vorgesehen sind Gesicht umarmt.

Mit Informationen: KI-StabilitätUnd Ars Technica

„Amateur-Musikpraktiker. Lebenslanger Unternehmer. Entdecker. Reisefan. Nicht entschuldigender Fernsehwissenschaftler.“

More Stories

Samsung Galaxy AI diesen Monat auf Portugiesisch aus Portugal

Plastik: Es gibt Chemikalien, die uns entgehen (insbesondere in recycelten Materialien) | Verschmutzung

Der potenzielle Landeplatz für die Mission zum Mond wurde enthüllt